CAUSE NATURALI DEL CAMBIAMENTO CLIMATICO A LIVELLO GLOBALE

Chiara Bertolin1

1Associate Professor at Norwegian University of Science and Technology (NTNU) – Department of Architectural Design, History and Technology.Trondheim, Norway

Concetti come global warming (o riscaldamento globale), variabilità climatica, meccanismi di feedback climatico (o retroazioni climatiche) sono entrati a far parte del nostro vocabolario quotidiano ma spesso le nozioni vengono usate in modo ripetitivo senza capirne a fondo il significato. Lo scopo dell’intervento: “cause naturali del cambiamento climatico a livello globale” è stato quello di introdurre, in modo semplice, alcuni dei concetti chiave utili alla comprensione del sistema climatico e di fare chiarezza su concetti di base che spesso sentiamo citati.

Qual è la differenza tra il concetto di variabilità climatica e meteorologica? Cos’ è un “cambiamento climatico” e come si manifesta? Quali sono le principali componenti del sistema climatico e come interagiscono tra loro attraverso meccanismi di feedback? Quali driving factors (o forzanti) “guidano” i cambiamenti Climatici? Come si possono distinguere le forzanti interne da quelle esterne al sistema?

Andiamo per ordine; spesso si sente parlare di variabilità meteorologica e climatica, ma qual è la differenza? Il TEMPO METEOROLOGICO riflette le condizioni a breve termine dell’atmosfera mentre il CLIMA definisce le condizioni medie (e la variabilità) del tempo meteorologico giornaliero su un periodo di tempo più esteso e/o su una certa area geografica. Con una visione “pratica” si può pensare che Il clima ti dice che vestiti comprare (a seconda della stagione), ma il tempo meteorologico ti dice quali vestiti indossare in quel preciso momento a causa delle condizioni di temperatura e/o alla presenza o meno di precipitazioni.

Quindi è chiaro che con il termine CLIMA si indica l’insieme delle proprietà che caratterizzano il tempo meteorologico di una regione geografica. Alcune di queste proprietà descrivono ad esempio come varia la temperatura nel corso delle stagioni, la quantità e la distribuzione (sia temporale che spaziale) delle precipitazioni, il regime dei venti, etc. Ma anche eventi estremi come la frequenza della siccità, delle grandinate anomale o delle trombe d’aria. Tutte queste caratteristiche influenzano la vita biologica e quindi sono fondamentali nel determinare il tipo di flora e fauna che si possono trovare in una determinata regione (IPCC WGI AR5. 2013). Molti dei fenomeni che nel loro insieme definiscono il clima si verificano come parte di sistemi organizzati su larga scala.

Se si sente parlare di CAMBIAMENTO CLIMATICO, si sta parlando quindi di cambiamenti del tempo meteorologico giornaliero su lungo periodo.

In una determinata area geografica, il tempo meteorologico può variare di minuto in minuto, ora in ora, giorno in giorno e stagione in stagione. Il clima tuttavia è la media del tempo meteorologico su un più ampio intervallo temporale e/o su una più ampia area spaziale.

Il clima, in una scala temporale, può definire una variabilità inter-annuale fino ad una variabilità che può ricoprire un arco temporale paragonabile al tempo di vita del nostro pianeta. Su una scala spaziale, il clima può variare da un versante all'altro nelle valli di montagna fino a variazioni su scala continentale. Tali cambiamenti possono riguardare variazioni nelle variabili climatiche (ad es. temperatura, quantità di precipitazione) in termini della loro quantità media e/o variabilità e/o frequenza di eventi estremi.

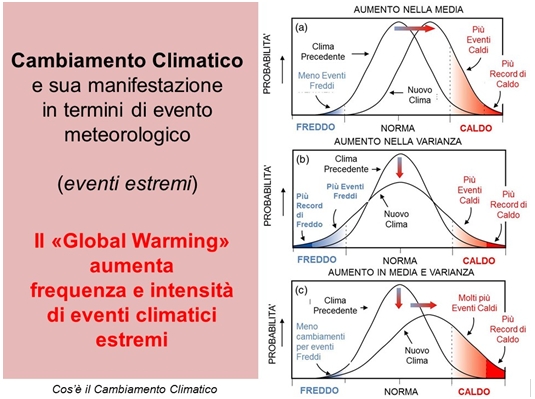

Una delle chiavi utili a comprendere come il clima stia mutando, e così anche la meteorologia locale, è l’analisi delle medie e delle varianze delle variabili meteorologiche e/o degli eventi meteo cosiddetti “intensi” (ad esempio inondazioni, onde di calore, siccità, trombe d’aria,..). In Figura 1 è ben spiegato il concetto della “manifestazione” del cambiamento climatico in termini di evento meteorologico ed in particolare del suo effetto sulla modificazione della frequenza di eventi cosiddetti estremi.

Figura 1: Esempio di Cambiamento Climatico riguardante la temperatura. Esso si puo’ manifestare in termini di aumento dei valori medi di temperatura (a); di aumento nella varianza (o variabilitá del fenomeno) delle temperature registrate (b) o in termini di aumento sia della media che della varianza (c).

Quando un EVENTO METEO può definirsi ESTREMO? I termini evento intenso ed evento estremo non sono affatto sinonimi, ma nascondono una fondamentale differenza: un evento meteo intenso è un qualsiasi fenomeno atmosferico che mette a rischio vite umane, mentre un evento meteo estremo è sì intenso quanto raro, in base alla statistica che descrive la probabilità che possa accadere in un determinato luogo. Un evento estremo si definisce come un record di temperature elevate o di quantità di precipitazioni.

Come si può vedere dai concetti espressi in Figura 1, il cambiamento climatico sta variando la statistica degli eventi estremi e la tendenza sembra portare verso un aumento della loro frequenza e/o intensità. Naturalmente il cambiamento climatico può “affliggere” in maniera diversa le diverse variabili meteorologiche; ad esempio ci si può aspettare un aumento, in termini di frequenza di inverni miti, ma al contempo ci si può attendere una diminuzione in frequenza di precipitazioni abbondanti nello stesso periodo temporale. La valutazione dell’effetto del cambiamento climatico in termini di occorrenza di eventi estremi dipende quindi dalla variabile che si sta prendendo in esame. L’effetto visibile può essere al contempo di eventi più o meno frequenti e/o più o meno intensi.

Procedendo con l’excursus nei concetti cardine per comprendere il sistema clima, ci si chiede: Quali sono le Componenti del sistema climatico?

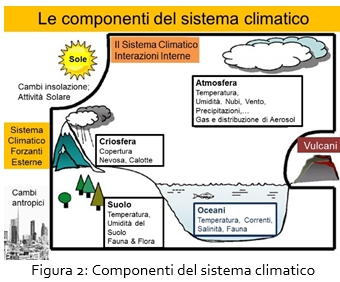

Il SISTEMA CLIMATICO rappresenta tutte le componenti che contribuiscono al clima. Esso è un sistema dinamico altamente complesso. Un approccio per comprendere, analizzare e modellizzare il clima come sistema è quello di dividerlo in componenti di più facile comprensione. Uno schema di questa semplificazione è dato in Figura 2.

Il sistema evolve a causa delle proprie dinamiche interne e a causa di cambiamenti in fattori esterni. Si hanno interazioni e cambiamenti tra tutte le componenti sia interne ed esterne al sistema.

Al suo interno il sistema climatico è composto da componenti quali:

- l' atmosfera che rappresenta l'insieme dei gas che circondano la terra, le cui molecole sono trattenute dalla forza di gravità del corpo stesso,

- l'idrosfera che è costituita dall'insieme delle acque presenti nel sottosuolo e nella superficie del pianeta,

- la criosfera che è la porzione di superficie terrestre coperta dall'acqua allo stato solido e che comprende le coperture ghiacciate di mari, laghi e fiumi, le coperture nevose, i ghiacciai, le calotte polari ed il suolo ghiacciato in modo temporaneo o perenne (permafrost),

- la litosfera (cioè parte rigida esterna del pianeta Terra) e

- la biosfera, definita in biologia come l'insieme delle zone della Terra in cui le condizioni ambientali permettono lo sviluppo della vita, e le interazioni tra esse.

Processi e dinamiche interne sono ad esempio circolazioni atmosferiche e oceaniche e meccanismi interni di feedback.

Variazioni in fattori esterni sono principalmente di tipo naturale dovuti a:

- Processi tettonici, cambi nella distribuzione di terra ed oceani, caratteristiche geografiche terrestri, la topografia del fondo degli oceani, temperature degli oceani e correnti oceaniche.

- Cambi nella composizione di base dell’atmosfera e degli oceani a causa delle attività naturali, ad esempio eruzioni vulcaniche che arricchiscono l’atmosfera di polveri e di gas. Le eruzioni esplosive più importanti possono portare ad un temporaneo raffreddamento in zone del pianeta anche distanti dal luogo dell’eruzione vulcanica.

- Cambi nella composizione dell’atmosfera dovuti all’azione antropica, (quindi forzanti di tipo antropico) dovuti ad esempio a: urbanizzazione, deforestazione, agricoltura intensiva, industrializzazione ed utilizzo delle risorse come combustione di combustibili fossili. Nel periodo recente si è appurato come l’origine antropica dell’inquinamento atmosferico possa modificare la composizione stessa dell’atmosfera. Ad esempio, l’aumento della concentrazione atmosferica dei gas-serra porta ad un generale riscaldamento a livello planetario. Anche le particelle emesse (aerosoli o aerosols) contribuiscono a questo bilancio radiativo.

- Le attività umane possono inoltre modificare le caratteristiche del territorio in termini di albedo (cioè del potere riflettente di una superficie) ad esempio distruggendo foreste (attraverso la deforestazione si ha quindi una modificazione nella vegetazione e quindi nell’albedo del suolo), creando laghi artificiali, facendo spazio a pascoli e campi coltivati, o a piste da sci, dove un tempo c’erano foreste. Queste azioni possono portare a cambiamenti nel sistema climatico globale o locale.

- cambi orbitali terrestri nella geometria terra-sole

- cambi nell’intensità dell’attività solare, variazioni di radiazione solare (in particolare dipendente dalla latitudine) entrante l’atmosfera, cambi naturali di insolazione

La risposta dell’intero “sistema climatico” dipende dalle forzanti, dalle caratteristiche delle diverse sfere o componenti, dai cicli e meccanismi di retroazione o feedback. La Comprensione del sistema climatico come si può quindi immaginare è assai complessa e richiede l'interazione di molte discipline scientifiche diverse e di diversi approcci.

Ma qual è il ‘motore’ di questo sistema climatico? Il motore è il sole.

Tuttavia, non tutta la radiazione solare che entra nell’atmosfera partecipa alla dinamica del clima. Una parte di questa radiazione viene riflessa. La riflessione (albedo) dipende dalle caratteristiche locali della superficie terrestre: i ghiacci e la neve fresca sono molto riflettenti, mentre la vegetazione o il mare lo sono poco.

La rimanente radiazione è assorbita dall’atmosfera terrestre e riscalda la terra. Tuttavia i meccanismi non sono così semplici poiché vi sono altri contributi:

la superficie terrestre irradia verso lo spazio energia in forma di radiazione infrarossa (IR) (al di fuori dello spettro visibile); le nubi contribuiscono ad aumentare sia la radiazione solare che viene riflessa nello spazio, sia la radiazione terrestre emessa nell’IR che viene trattenuta in atmosfera anche dai cosiddetti gas serra, (biossido di carbonio, metano, fluorocarburi, …), che definiremo più avanti nel testo, che, intrappolando la radiazione IR emessa, riscaldano gli strati atmosferici più bassi e la superficie stessa.

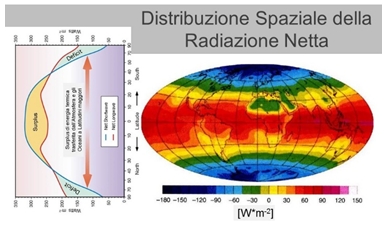

Come appare quindi la distribuzione spaziale della RADIAZIONE SOLARE NETTA sulla superficie terrestre? Dai meccanismi sopra descritti si capisce come la radiazione solare netta assorbita dalla terra alla cima dell’atmosfera (misurata in W m-2) sia anti correlata all’albedo, risultando maggiore ai tropici per via del basso angolo zenitale solare e della maggior presenza degli oceani, e minore ad alte latitudini a causa della bassa insolazione, del grande angolo zenitale solare, della maggior presenza di nubi e ghiaccio. All’opposto la radiazione IR emessa dalla terra alla cima dell’atmosfera (sempre misurata in W m-2) è funzione della superficie terrestre (i.e. minimi valori ai poli, massimi valori sopra zone calde e secche come i deserti subtropicali) con aree equatoriali umide che emettono meno radiazione delle aree secche tropicali.

Conseguentemente il bilancio netto illustrato in Figura 3 mostra i valori annuali della radiazione netta a lunghezze d’onda corte (colore blu) e lunghe (colore rosso) dal polo sud al polo nord. Si vede che queste aree non hanno lo stesso valore. Da 0-35° di latitudine Nord e Sud, la radiazione solare entrante in atmosfera supera la radiazione uscente (i.e. la radiazione emessa dalla terra a lunghezze d’onda IR). Esiste quindi in queste zone un surplus di energia. Il contrario è invece vero a latitudini comprese tra 35-90° N ed S dove si osserva un deficit in energia. Nell’insieme, il surplus di energia a basse latitudini ed il deficit di energia ad alte latitudini, risulta in un trasporto di energia dall’equatore verso i poli. Il trasporto di energia avviene lungo i meridiani ed innesca la circolazione atmosferica e oceanica. Se questo trasporto non esistesse, i poli sarebbero 25°C più freddi, e l’equatore 14°C più caldo e la vita sul nostro pianeta non sarebbe possibile.

Figura 3: Distribuzione spaziale della radiazione solare netta sulla superficie terrestre misurata in W*m-2. In rosso valori positivi di surplus di energia all`equatore ed ai tropici; in blu, valori negativi con deficit di energia ai poli.

Le circolazioni atmosferiche ed oceaniche (processi di trasporto all’interno del sistema climatico) trasportano energia verso i poli e la distribuiscono attorno alla terra; esse agiscono quindi per compensare il surplus di radiazione netta presente nelle regioni equatoriali e tropicali ed il deficit nelle regioni polari, (Figura 3) riducendo in questo modo il gradiente di temperatura tra equatore e polo.

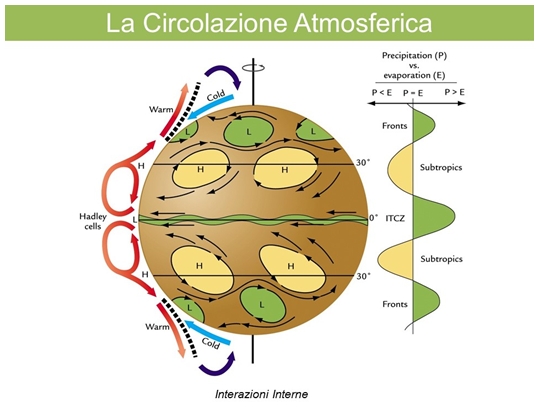

Quali sono i meccanismi attraverso i quali si realizza il TRASPORTO ATMOSFERICO?

I meccanismi della circolazione atmosferica differiscono a latitudini tropicali ed extratropicali (Walker, G. 2009). Ai tropici, la maggioranza del trasporto di calore atmosferico verso i poli è dato dalla circolazione di Hadley (vedi Figura 4), tipicamente convettiva che genera:

- Moto ascendente vicino all’equatore

- a 10 km di altezza dal suolo, vicino alla tropopausa, moto verso i poli

- Moto discendente nella zona subtropicale e

- Flusso che ritorna verso l’equatore vicino alla superficie terrestre

All’opposto, a latitudini maggiori, il trasporto di energia è svolto da cicloni e anticicloni che fanno in modo che l’aria relativamente calda si muova verso i poli e l’aria fredda si muova verso l’equatore (Figura 4).

Figura 4: Schema della circolazione atmosferica con i meccanismi di trasporto dati dalla circolazione di Hadley (ai tropici) ed i meccanismi svolti da cicloni ed anticicloni nelle zone a latitudini maggiori.

L’altro grande processo globale di trasporto di energia e materia all’interno del sistema climatico è svolto dalla CIRCOLAZIONE OCEANICA. Le correnti oceaniche superficiali (calde che si muovono verso i poli) sono guidate da:

- venti con schemi determinati dalla direzione del vento,

- Forza di Coriolis

- posizione dei continenti

Le correnti superficiali guidate dai venti (come la Corrente del Golfo) viaggiano verso i poli dall’oceano atlantico equatoriale, raffreddandosi lungo la strada ed infine “affondando” verso latitudini maggiori andando a formare così l’acqua profonda Nord Atlantica (cioè la North Atlantic Deep Water). L'acqua sprofonda, a queste latitudini, sia per la bassa temperatura, che per l'elevata salinità causata dalla formazione della banchisa (i.e. una massa di ghiaccio marino galleggiante di al massimo 3m che si forma per il congelamento dell'acqua dell'oceano). Questa acqua quindi densa fluirà nel fondo degli oceani.

La maggior parte di queste masse d’acqua, ritornerà in superficie negli Oceani a Sud poiché l'acqua di fondo, muovendosi verso l'equatore, interagirà con altre masse d’acqua diminuendo così la propria densità. Invece, le acque più vecchie e profonde ritorneranno in superficie (con un tempo di transito di circa 1000 anni) nel Nord Pacifico come rappresentato in Figura 5. Lungo il loro viaggio, le masse d’acqua trasportano sia energia (in forma di calore) che materia (solidi, sostanze disciolte e gas) attorno al globo. In questo modo, lo stato della circolazione ha un grande impatto sul clima terrestre. Si intuisce quindi che le correnti oceaniche profonde, caratterizzate da tempi scala molto lunghi, da decine a migliaia di anni, sono guidate dalla circolazione Termoalina cioè dalla variazione nella densità dell’acqua marina, densità che varia appunto come dice il termine (termoalina) in funzione di temperatura e salinità.

Figura 5: Schema della circolazione oceanica con l`esteso “nastro trasportatore” della circolazione termoalina.

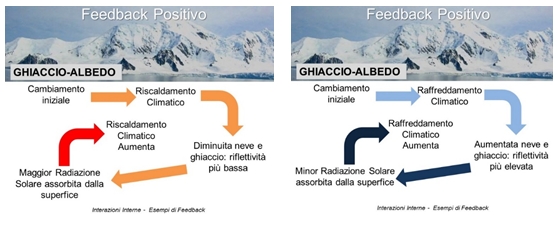

Giunti a questo punto ci si potrebbe chiedere quale potrebbe essere l’effetto sull’intero sistema climatico se ad esempio il ghiaccio della banchisa si sciogliesse magari per effetto dei cambiamenti climatici. La risposta a questa domanda richiede l’introduzione di un altro concetto che ritorna spesso quando si parla di clima e di cambiamenti climatici e cioè il concetto di retroazione o feedback. Un feedback è Un meccanismo di interazione tra i processi nel sistema climatico in cui il risultato di un processo iniziale innesca cambiamenti in un secondo processo che a sua volta influenza quella iniziale (IPCC WGII AR5 2014, Glossary).

Un meccanismo che mentre avviene un cambiamento iniziale in un processo, tenderà a rinforzare il cambiamento è un feedback positivo, se invece tenderà ad indebolire lo stesso è un feedback negativo.

Figura 6: Esempi di meccanismi di retroazione o feedback positivo con effetti diversi in termini di impatto climatico.

Ritornando all’esempio della banchisa, sebbene sottile, la superficie assai riflettente, contribuisce di molto all’albedo terrestre cioè alla radiazione solare riflessa nello spazio. Quindi se la banchisa si sciogliesse, ciò comporterebbe una minor riflessione dei raggi solari con effetto di feedback positivo che aumenterebbe il riscaldamento (Figura 6a)

All'opposto durante un raffreddamento climatico con conseguente aumento dei ghiacci, si avrebbe una maggiore albedo e quindi riflessione; ciò farebbe diminuire la temperatura con effetto di feedback positivo e conseguente ulteriore aumento dei ghiacci (Figura 6b).

Parlando del sistema climatico abbiamo distinto in Figura 2 tra interazioni interne tra le sue componenti, di cui abbiamo già parlato, e forzanti esterne. Una volta che si applica una forzante esterna, i feedback interni complessi determinano la risposta finale del sistema climatico, in termini di riscaldamento o raffreddamento, che differiscono da una semplice risposta lineare. Qual è quindi la forzante esterna più importante per il nostro sistema climatico? La FORZANTE ESTERNA più importante è la luce solare che fornisce una fonte di energia “costante”. Il bilancio radiativo terrestre è la relazione tra l’energia proveniente dal sole in atmosfera e quella uscente. Se il risultato è positivo, ci sarà del riscaldamento, se il risultato è negativo ci sarà del raffreddamento. Oltre alla forzante solare, altre forzanti naturali e antropiche che possono indurre un cambiamento climatico sono: i vulcani, gli aerosols, i gas cosiddetti serra. E’ tuttavia complesso calcolare il bilancio radiativo terrestre poiché questi fattori hanno ognuno la propria incertezza. Ad esempio, le particelle AEROSOLS, affliggono il bilancio radiativo in maniera complessa. Possono avere un effetto di interazione diretto con la radiazione solare che può causare sia raffreddamento che riscaldamento. Nel caso di aerosol solfati, chiari e brillanti, questi riflettono la radiazione solare, diminuendo la radiazione incidente con conseguente effetto di raffreddamento della superficie terrestre; nel caso invece di aerosol scuri, come ad esempio la cenere, questi assorbono la radiazione solare provocando riscaldamento. Spesso questi aerosol sono di origine antropica, emessi da veicoli ed incendi boschivi ed eiettati in troposfera. Aerosol di origine antropica (derivanti da inquinamento antropico) possono avere anche un effetto indiretto poiché possono agire come nuclei di condensazione nella formazione di nubi. Questo porta ad accrescere l’effetto albedo delle nubi che appaiono più riflettenti, bianche e grandi portando ad un raffreddamento di -0.3 and -1.8 Wm−2.

Tuttavia rimane il sole il principale “motore” che determina il clima. Lo studio dell’interazione tra attività solare e variazioni climatiche terrestri ha portato all’osservazione dell’attività sulla superficie del sole e alla misurazione, fin dal 1700, del numero di macchie che apparivano sulla sua superficie. Successivamente si è scoperta la periodicità della comparsa di queste macchie in un ciclo di 11 anni. Il clima è influenzato dal numero medio annuo delle Macchie Solari. Si stima che le fluttuazioni normali dovute ai cicli solari aumentino o diminuiscano la radiazione solare che raggiunge la terra di circa 0.1-0.2 %. Nei periodi in cui l’attività solare è stata minima, vi è stato una maggiore frequenza di eventi estremi quali inverni molto rigidi come durante la Piccola Età Glaciale (nota come Little Ice Age) che ha compreso tre periodi minimi di attività solare (Camuffo et al. 2014): il minimo di Spoerer (1416-1534), il minimo di Maunder (1645-1715) ed il minimo di Dalton (1800-1830).

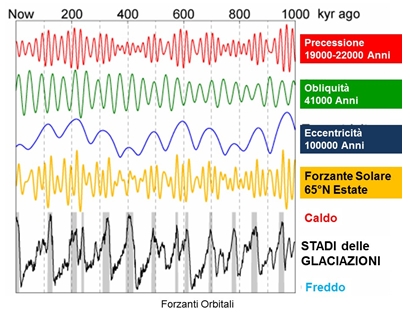

Altri fattori Astronomici che modificano l’irraggiamento solare sulla Terra sono costituiti dalle forzanti orbitali, descritti da Milankovich nella sua Teoria (Zachos et al. 2001). In questo caso, i cambiamenti climatici sono dovuti alla variazione di parametri orbitali nei moti terrestri, quali: eccentricità, inclinazione dell’asse terrestre, e precessione dell’orbita terrestre.

ECCENTRICITÀ: L’effetto del cambiamento dell’eccentricità dell’orbita terrestre (nel tempo, l'eccentricità dell'orbita terrestre varia lentamente) è su lungo termine con periodo dominante di 100000 anni ed è una delle cause che contribuiscono all’alternanza delle glaciazioni poiché influenza l’apporto solare variando la forma dell’orbita terrestre. Infatti, a seconda dell'eccentricità dell'orbita, la massima distanza terra-sole e quella minima possono essere più o meno differenti dalla distanza media, rispettivamente 152,1 milioni di km (2,5 milioni di km più della sua distanza media) all’afelio (dal greco αφήλιον, da από, apò = "lontano" e ήλιος, èlios = "sole") e 147 milioni di chilometri dal Sole, (2,5 milioni di chilometri meno della distanza media) al perielio (dal greco perì = intorno, helios = sole).

L'eccentricità dell'orbita della Terra oggi è 0,0167. Nel tempo, varia e passa da quasi 0 a circa 0,05 come risultato dell'attrazione gravitazionale con gli altri pianeti. Quando l’eccentricità è prossima allo 0, l’orbita è circolare e mantiene la Terra sempre alla stessa distanza dal Sole; quando invece l’eccentricità aumenta a valori compresi tra 0 e 1, l’orbita ellittica la fa alternativamente avvicinare e allontanare dal sole, variando la quantità di radiazione in arrivo sulla Terra.

L’INCLINAZIONE DELL’ASSE TERRESTRE: La pendenza dell’asse di rotazione terrestre, cambia la radiazione solare che raggiunge la Terra e permette l’alternarsi delle 4 stagioni. Tuttavia, l’angolo di inclinazione dell’asse terrestre non è costante nel tempo e cambia con un periodo di circa 41000 anni. Con minor inclinazione dell’asse terrestre le regioni polari ricevono meno energia dal Sole, mentre, con un’inclinazione maggiore, l’aumentano. Quindi questo tipo di variazione ha un grande impatto alle alte latitudini (poli) ed un impatto minore ai tropici.

LA PRECESSIONE DEGLI EQUINOZI: L’attrazione gravitazionale della luna e del sole tende a modificare la direzione dell’asse di rotazione terrestre e l’esposizione ai raggi solari nei due emisferi e nelle 4 stagioni. Il risultato di questo effetto combinato sulla distanza dal Sole e l’inclinazione dell’asse terrestre può accrescere o ridurre la stagionalità. Il periodo di precessione varia tra 19000 e 23000 anni. La sommatoria di tutti questi effetti può aiutare a spiegare le variazioni del clima terrestre causate dalla forzante solare come ad esempio gli stadi delle glaciazioni rappresentate in Figura 7.

Figura 7: La sommatoria di tutti gli effetti dei cambiamenti delle forzanti orbitali terrestri aiutano a spiegare le variazioni del clima terrestre causate dalla forzante solare come ad esempio gli stadi delle glaciazioni.

Un'altra forzante esterna naturale è costituita dalle ERUZIONI VULCANICHE. Durante le eruzioni vulcaniche sono rilasciate una grande quantità di gas (vapor acqueo, anidride carbonica e diossido di zolfo) e particelle solide iniettate in atmosfera fino alla stratosfera (i.e. lo strato di atmosfera che si trova al di sopra la tropopausa ad una altezza tra i 12 ed i 50 chilometri). Le particelle solide come la cenere vulcanica cadono rapidamente a causa delle proprie dimensioni e massa, quindi grandi volumi di ceneri bloccano la radiazione solare entrante ma l’effetto è meno significativo in termini di impatto sul sistema climatico poiché è a più breve termine.

I gas invece sono quelli che forzano maggiormente la risposta del sistema climatico. Il vapor acqueo e l’anidride carbonica non cambiano di molto i livelli ambientali. Invece il gas solforoso SO2, in combinazione con l’acqua, forma acido solforico che poi condensa su particelle per formare aerosol di solfati. Gli aerosol solfati sono chiari e riflettono la radiazione incidente quindi aumentano la brillantezza (albedo) delle nubi riducendo la radiazione solare che raggiunge la terra e causando in questo modo una grande perturbazione nella radiazione solare netta. Gli aerosol nella stratosfera, che bloccano all’esterno la radiazione solare, richiedono un tempo di deposizione maggiore.

Ad esempio, grandi eruzioni come quelle del monte Pinatubo sono state collegate a significanti episodi di raffreddamento del clima terrestre. Tre mesi dopo l’eruzione di questo vulcano nelle Filippine, evento accaduto in giugno 1991, gran parte dei 20 milioni di tonnellate di biossido di zolfo, espulse, si erano dirette grazie ai venti zonali stratosferici e depositate verso le regioni equatoriali.

Cambi nelle temperature registrate nei secoli passati indicano le influenze delle eruzioni vulcaniche sul clima. Un esempio di cui si parlerà in questi Atti è l’anno 1816, definito l’anno senza estate (anno in cui Mary Shelley scrisse Frankenstein), anno in cui si ebbero abbondanti nevicate e gelate in giugno in centro Europa. Questi eventi climatici coincisero con il periodo successivo alla massiccia eruzione vulcanica del vulcano Tambora.

Tra le FORZANTI ANTROPICHE invece vi sono i Gas cosiddetti serra. Che cos’è quindi l’effetto serra? Dai concetti esposti fino adora abbiamo compreso come i raggi solari riscaldino la superficie della Terra e come a sua volta, la Terra irradi energia nuovamente verso lo spazio nelle lunghezze d’onda IR. L’atmosfera terrestre è trasparente alla luce visibile ma non completamente all’ infrarosso. Infatti i gas atmosferici cosiddetti serra o Greenhouse Gases (i.e. vapor acqueo H20, anidride carbonica CO2, Ossido di diazoto N2O, metano CH4, ozono 03, Clorofluorocarburi CfC…) intrappolano parte dell'energia uscente, conservandone il calore, comportandosi proprio come i vetri di una serra. Senza questo "effetto serra naturale", le temperature sarebbero più basse, di 33°C, rispetto quelle attuali e la nostra vita non sarebbe possibile. Invece, grazie ai gas serra di origine naturale, la temperatura media della Terra è di 15,5°C anziché -18°C. Nonostante quindi le piccole concentrazioni, CO2, vapor acqueo e metano sono componenti fondamentali per l’equilibrio radiativo del sistema climatico poiché intrappolano la radiazione infrarossa rimettendola nuovamente nell’intervallo termico infrarosso portando così ad un riscaldamento.

Tuttavia oggi si sente parlare di GAS SERRA con accezione negativa: per quale ragione? Quando si sente parlare di gas serra inoltre si sente parlare spesso di anidride carbonica che è una sostanza fondamentale nei processi vitali delle piante e degli animali ed è indispensabile per la vita e per la fotosintesi delle piante, ma è anche responsabile dell'aumento dell'effetto serra e del riscaldamento cosiddetto globale. Si ipotizza che la concentrazione atmosferica di diossido di carbonio prima della rivoluzione industriale fosse 280 parti per milione in volume (ppmv), e che quindi la sua concentrazione sia aumentata fino a 390 ppmv nel 2010. La causa di tale aumento è da ricercarsi nell’uso intensivo di combustibili fossili (carbone, petrolio) nelle economie mondiali e nella deforestazione. https://it.wikipedia.org/wiki/Anidride_carbonica - cite_note-8 Tuttavia come abbiamo visto la CO2 non è il solo gas serra; il vapor acqueo è infatti il più importante gas serra in termini di contributo all’effetto naturale (circa il 60%). Circa il 99.13% di questo gas è contenuto nella troposfera (i.e. i primi 10 km di strato atmosferico al di sopra della superficie terrestre). La condensazione del vapor acqueo in fase liquida o solida (sotto forma di ghiaccio) è responsabile per l’idrosfera e la criosfera. Infine a titolo esemplificativo, l’altro gas serra che spesso si sente citato e che può essere ancora una volta sia di origine naturale che antropica è il metano. Il metano è un gas serra presente nell'atmosfera terrestre in concentrazioni molto inferiori a quelle della CO2.

Le principali fonti di emissione di metano nell'atmosfera sono:

- decomposizione di rifiuti solidi urbani nelle discariche

- fonti naturali (paludi): 23%

- estrazione da combustibili fossili: 20%

- processo di digestione degli animali (bestiame): 17%

- batteri trovati nelle risaie: 12%

- riscaldamento o digestione anaerobica delle biomasse.

Tra il 60% e l'80% delle emissioni mondiali di questo gas è di origine umana, derivanti principalmente da miniere di carbone, discariche, attività petrolifere, gasdotti e agricoltura.

La sua concentrazione in atmosfera è aumentata da 700 ppb (parti per miliardo) nel periodo 1000-1750 a 1.750 ppb nel 2000, con un incremento del 150%.

CONCLUSIONI:

La comprensione del sistema climatico è assai complessa, richiede l'interazione di molte discipline scientifiche e di diversi approcci. Ancora molti aspetti rimangono da studiare approfonditamente per migliorare l’attendibilità degli scenari futuri in termini di determinazione della variabilità climatica, di stima dell’incremento delle temperature e delle relative incertezze così da migliorare le proiezioni e la conseguente comprensione dei rischi e degli impatti del clima sulla società.

Punti chiave in cui migliorare la comprensione e modellizzazione riguardano:

- gli aspetti degli scambi atmosfera – oceani;

- gli aspetti della dinamica della turbolenza; la convezione atmosferica infatti è un classico esempio di fenomeno fisico che un modello climatico ha dei limiti a simulare, poiché intense correnti ascensionali convettive hanno dimensione orizzontale di pochi km e non possono essere adeguatamente risolte dai modelli;

- gli aspetti dello studio delle interazioni (e delle conseguenti propagazioni di incertezze) attraverso le scale globale (Global Climate Model) e regionale (Regional Climate Model);

- gli aspetti nella rappresentazione fisico-matematica delle interazioni delle componenti interne al Sistema Climatico (i.e. meccanismi di retroazione o feedback) al fine di ottenere livelli di confidenza maggiori nelle proiezioni climatiche future ed infine la comprensione degli effetti degli aerosol sul clima.

BIBLIOGRAFIA:

Camuffo, D., Bertolin, C., Schenal, P., Craievich, A. and R. Granziero. 2014. The Little Ice Age in Italy from documentary proxies and early instrumental records. Journal of Mediterranean Geography 122 : 17-20.

IPCC WG I AR5. 2013. Contribution to the Fifth Assessment Report of the Intergovernmental Panel on Climate Change. “Climate Change 2013: the physical science basis” Edited by Stocker F.T., Qin, D., Plattner, G-K. Tignor, M., Allen, S., Boschung, J., Nauels, A., Xia Y., Bex, V. and P. Midgley. Cambridge University Press.

IPCC WGII AR5 Glossary. 2014. Glossary of Terms used in IPCC Fifth Assessment Report 2014.

Walker, G. "Un oceano d'aria" - ed. codice, 2009, op. cit. p.102

Zachos, J.C., Shackleton, N.J., Revenaugh, J.S., Palike,H. and B. P. Flower. 2001 Climate Response to Orbital Forcing Across the Oligocene-Miocene Boundary. Science, 292, 5515: 274-278. DOI: 10.1126/science.1058288

IL CLIMA DELL’ULTIMO MILLENNIO: METODI, CERTEZZE E INCERTEZZE

Dario Camuffo

CNR, Istituto di Scienze dell’Atmosfera e del Clima, Padova

La nostra conoscenza del clima si basa su osservazioni oggettive dirette e indirette. Le osservazioni sono alla base di ogni ipotesi: dei meccanismi e delle relazioni tra le cause forzanti e gli effetti che regolano le vicende del clima; delle equazioni che le descrivono l’evoluzione; dello sviluppo, della taratura e della verifica dei modelli di simulazione numerica che hanno lo scopo di chiarire e sviluppare interpretazioni e previsioni a seconda dei parametri scelti o delle supposizioni che possono venire avanzate. Le osservazioni dirette sono di tipo strumentale, e costituiscono l’informazione più precisa. In assenza di misure strumentali dirette si possono utilizzare indicatori indiretti sostitutivi, chiamati “proxy” (che significa “dati per procura”). Vi sono vari tipi di osservazioni indirette, che possono derivare da archivi naturali (es. anelli di crescita degli alberi (dendrocronologia), il ritiro dei ghiacciai, il livello di corpi d’acqua) o documentari (es. fonti scritte, arti visive). Le documentazioni scritte sono costituite da dati d’archivio con descrizione di fenomeni e del loro impatto, cronache, diari ecc. Particolari rappresentazioni pittoriche eseguite con la “camera oscura” possono essere usate per ricostruire il livello del mare a Venezia (Veronese, Canaletto, Bellotto), o documentare il congelamento di fiumi e della laguna veneta. I dati di tipo Proxy possono sostituire le osservazioni strumentali purché siano suffragati da fattori valutabili oggettivamente come a es. l’impatto sull’ambiente o sulla società. Le ricostruzioni climatiche su lungo periodo si basano necessariamente sulla combinazione di osservazioni strumentali e di proxy di vario tipo. Tuttavia, occorre tener presente che tutte le osservazioni, dirette e indirette, sono affette da incertezze (errori) di vario tipo, con bande d’incertezze variabili col tempo e con l’osservatore, e molto spesso sottovalutate. Lo scopo di questo intervento è di illustrare il problema con qualche esempio.

Le osservazioni strumentali dirette

Le osservazioni dirette sono di tipo strumentale, e le prime in assoluto risalgono alla Rete del Granduca di Toscana, dal 1654 al 1570 cui si deve l’invenzione del termometro a liquido e l’istituzione della prima rete internazionale di misura, con osservazioni omogenee secondo un preciso protocollo di misura, e effettuate a intervalli regolari sia di giorno che di notte (Camuffo e Bertolin, 2013). I termometri fiorentini erano identici fra loro, con la stessa scala. Erano costruiti interamente in vetro, a parte il liquido sensibile (alcol) e potevano resistere alle intemperie. Alcuni di questi termometri, del tipo noto come “Piccolo Termometro Fiorentino” continuarono ad essere usati come nella serie di Parigi (Builleau) o per la determinazione sperimentale delle leggi dei gas (Boyle).

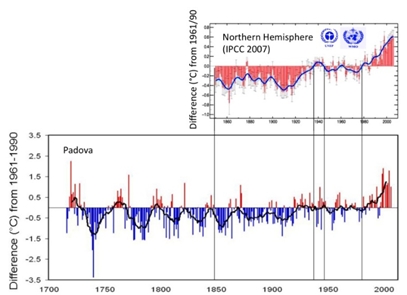

Dopo il periodo critico determinato dal processo di Galileo e la persecuzione da parte dell’Inquisizione degli Accademici del Cimento e delle osservazioni meteorologiche in generale, in Italia le serie meteorologiche ripresero timidamente dopo la prima decade del XVIII secolo. Una di queste importanti serie è quella di Padova, iniziata da Giovanni Poleni nel 1716, e poi regolarmente nel 1725 (Camuffo e Jones, 2002), e protratta sino a oggi (Fig.1).

Fig.1 Temperatura media annua nell’Emisfero Nord (in alto, dati IPCC 2007) e a Padova. La linea spessa costituisce la media mobile su 11 anni. I dati sono espresso in termini di “anomalia”, vale a dire di differenza rispetto al period di riferimento 1961/90.

Dopo il primo successo delle misure meteorologiche, l’elevato costo di strumenti di buona qualità causarono una svolta: dalla seconda metà del 1600 alla fine del 1700 le misure vennero per la maggior parte effettuate all’interno degli edifici o con brevi esposizioni manuali all’aperto in quanto i termometri erano basati su una tecnologia povera che non resisteva all’aperto, soprattutto perché i tubicini in vetro erano fissati con fil di ferro su tavolette di legno che si deformava con l’umidità ambiente. A questo contribuì anche il fatto che le persone vivevano in case malsane e le misure climatiche indoor erano considerate importanti ai fini della salute pubblica. Tuttavia, dalle origini al 1860 i dati sono generalmente scarsi e con varie interruzioni.

Nel 1860 George Biddel Airy (dell’Osservatorio di Greenwich Observatory) e Urbain Jean-Joseph Le Verrier (dell’Osservatorio di Parigi) stabilirono la prima collaborazione internazionale per la previsione delle tempeste. Nel 1873, sotto la direzione di Christoph Buys Ballot, fu fondato il Comitato Meteorologico Internazionale che coordinò l’azione dei vari servizi meteorologici nazionali da poco istituiti. Nel 1950, il Comitato divenne l’Organizzazione Meteorologica Mondiale formata da 160 paesi membri, sotto la direzione delle Nazioni Unite (WMO, 2009).

Nel corso dei secoli si sono via via sviluppati la conoscenza della meteorologia, la costruzione degli strumenti tradizionali o le misure da satellite, i protocolli e le modalità di osservazione. Queste vicende hanno introdotto forti discontinuità nella risposta strumentale, nell’esposizione o negli schermi applicati agli strumenti, nell’effettuare la lettura e la media delle osservazioni, cambiando punto di misura, livello rispetto al suolo, alterando le caratteristiche fisiche dell’ambiente attorno alla stazione mete, e passando da città a aperta campagna. Occorre ricordare che il termometro misura la temperatura del proprio bulbo. Non è detto che questo sia esattamente rappresentativo della temperatura dell’aria. Siamo noi che assumiamo lo sia, prendendo qualche precauzione contro i fattori di disturbo, come raccomandato da guide internazionali (WMO, 2008).

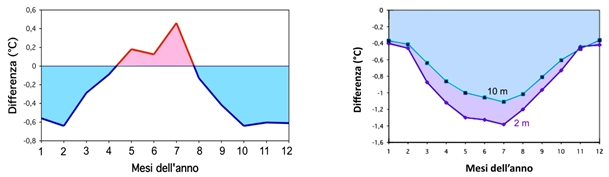

Il problema non va riferito solo alle prime osservazioni pionieristiche, ma anche in tempi relativamente moderni, quando lo sviluppo della tecnologia o il cambiamento di protocolli per le osservazioni ha introdotto deviazioni anche consistenti ai valori medi delle variabili osservate, con effetto simultaneo su tutte le stazioni (Camuffo e Jones, 2002). Per esempio, nel coso del tempo la media venne effettuata in modi diversi: media fra gli estremi (semisomma tra Min e Max (Fig.2a); tra due letture di cui una al mattino e una a mezzogiorno o di primo pomeriggio, poi 3 letture: mattina pomeriggio e sera, poi 4 letture intervallate (Fig.2b), poi 24 letture, infine la registrazione continua. L’indicazione di quando fare le letture e come fare le medie venivano date dalle autorità competenti a livello nazionale o internazionale. Ogni cambiamento di protocollo ha le stesse apparenze di un forte cambiamento climatico.

Fig.2 (a): Errore per le medie di temperatura giornaliera a Padova calcolate come (Tmax+Tmin)/2, come frequentemente in uso nel XVII e nel XVIII secolo. (b): Errore per le medie di temperatura giornaliera a Padova (per una stazioncina a 2 m e una a 10 m) basate su tre osservazioni alle ore 8, 14, 20, come prescritto dall’Ufficio Centrale di Meteorologia e Geodinamica, Roma, nel periodo tra il 1868 e il 1920.

Lo schermo termometrico, necessario per riparare i termometri dalla radiazione solare diretta era inizialmente assente e ha avuto la sua evoluzione. La prima notizia di consapevolezza di uno schermo risale a un’osservazione di Toaldo a Padova, nel 1785. Gli schermi cominciarono a essere usati verso il 1830, e divennero d’obbligo a partire dal 1860 (Middleton, 1966). La capannina standard bianca a gelosie in legno, nota come Stevenson Screen, può causare un surriscaldamento di +1.5°C di giorno e un raffreddamento di -0.5°C di notte (Cicala A., 1970). In casi di assenza di vento e forte insolazione il surriscaldamento può giungere a +2.5°C (WMO, 2008). Durante i temporali estivi lo schermo che si bagna e evapora può abbassare la temperatura di vari gradi sino a raggiungere il livello di bulbo bagnato. I moderni schermi a dischetti metallici o in PVC sovrapposti danno una risposta ancora diversa. Vanno evitate le perturbazioni da corpi vicini e l’influenza del suolo (va posto su un prato ad erba verde, a 2 m d’altezza, lontano da edifici, piante o altri oggetti di grandi dimensioni). Una capannina posta a un’altezza diversa sopra un terreno brullo o uno spiazzo pavimentato darà indicazioni fortemente diverse da quelle standard.

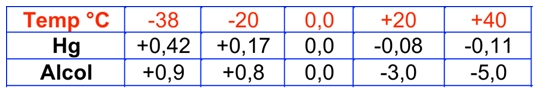

La taratura dei termometri è sempre stato un punto delicato e carente, specie agli inizi della meteorologia. Per oltre un secolo solo il sensore veniva immerso nel ghiaccio o nel vapore, lasciando il cannello in condizioni termiche diverse. I punti riferimento erano incerti e non realizzati a pressione standard, il che poteva generare un errore di ±1°C per la scala Celsius o anche ±5°C per la Fahrenheit. Importanti errori erano dovuti alla non-linearità dell’espansione dei fluidi. I gradi intermedi tra i punti fissi erano calcolati per interpolazione lineare; il problema era trascurabile per i termometri a mercurio, ma non per quelli ad alcol dove l’errore di linearità è molto forte (raggiunge -2°C a 20°C temperatura ambiente), come riportato in tabella .

Tabella I: deviazione dalla linearità di un termometro a a mercurio (Hg) e uno ad alcol.

L’idea di tarare il termometro Fahrenheit con la temperatura corporea (32°C) come punto superiore, ispirata a Santorio, non era malvagia: nei paesi dell’Europa settentrionale, il limite superiore era quello realistico della temperatura estiva. L’errore di non-linearità scendendo dal punto di ebollizione dell’acqua sarebbe stato senz’altro superiore.

I proxy: le osservazioni indirette

I dati proxy, specie quelli di natura documentaria-archivistica, sono per loro natura qualitativi. Per essere utilizzati devono essere trasformati in indici numerici e, grazie a periodi con simultanea presenza di osservazioni strumentali e osservazioni proxy è possibile tarare la scala e attribuire un valore quantitativo a dei dati che inizialmente ne avevano uno qualitativo soltanto. Tuttavia, anche i proxy sono affetti da limiti e incertezze. Ad esempio i dati documentari scritti e la dendrocronologia sono molto utili a decifrare le fluttuazioni e la variabilità sul breve periodo, ma non i trend. Altri hanno invece caratteristiche opposte.

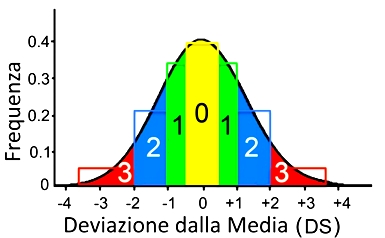

Tipicamente, i dati proxy danno un’informazione qualitativa o un’indicazione classificabile quantitativamente (indice) che può essere trasformato in unità meteorologiche moderne. In questo caso l’indice proxy deve essere calibrato con le moderne osservazioni strumentali per dare una ricostruzione quantitativa del clima passato (Camuffo et al., 2013). La classificazione degli eventi viene fatta attribuendo 7 livelli di severità compresi tra ±3. Il livello Zero (0), per definizione, è quello più ricorrente (cioè la moda) che al tempo della scrittura era (soggettivamente) considerato il più normale e pertanto non faceva notizia. Più che da informazioni dirette, si ricava dall’assenza di informazione. Poiché il livello di base 0 è soggettivo e legato all’esperienza del testimone, non è possibile determinare trend o cambiamenti sul lungo periodo. I livelli ±1 e ±2 sono livelli di severità intermedia. L’estremo superiore +3 è costituito da casi di eccesso eccezionale e ben documentato (esempio: caldo) e -3 è il caso opposto (es. freddo estremo). Per ogni indice si applica un criterio basato sulle distribuzione delle frequenze che corrisponda alle osservazioni strumentali, come per es. la distribuzione percentile. Per rendere più semplice l’esemplificazione, la temperatura (non la precipitazione!) segue una distribuzione Gaussiana, centrata sulla media e simmetrica. Una Gaussiana può essere definita in termini di deviazione standard (DS) e di popolazione geometrica. Se si classificano le osservazioni strumentali e i dati proxy in termini di classi di severità, ogni classe è compresa negli intervalli di popolazione ±0.5 DS, ±1 DS, ±2 DS e valori esterni a ±2 DS, come rappresentato in Fig.3.

Fig. 3. Come passare da indice a unità moderne: confronto tra la distribuzione delle osservazioni indicizzate in classi di severità (istogrammi), e l’analoga distribuzione delle classi per una distribuzione Gaussiana.

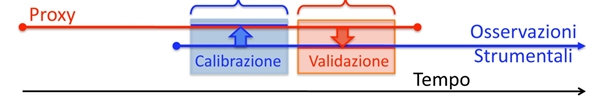

Per passare da un indice descrittivo a unità moderne (per esempio una temperatura espressa in °C), occorre passare attraverso quattro fasi operative, come segue (Fig.4).

(i) Periodo comune: E’ necessario disporre di dati proxy e osservazioni strumentali per un periodo in comune. Gli oggetti contenuti nell’intervallo comune delle due serie devono coincidere perché rappresentano gli stessi eventi, solo che sono espressi in unità diverse.

(ii) Calibrazione: I valori delle osservazioni strumentali (espresse in °C) vengono attribuiti ai valori proxy corrispondenti, rendendo in chiaro i valori che appartengono alle classi ±0.5 DS, ±1 DS, ±2 DS, <±2 DS<

(iii) Validazione: Una volta che l’esercizio di calibrazione sia stato fatto su un periodo comune, la metodologia deve essere verificata su un altro periodo indipendente comune facendo l’esercizio inverso: ricreando i dati strumentali partendo dai proxy.

(iv) Estensione. Se il risultato della verifica è stato positivo, il risultato della calibrazione viene esteso alla parte precedente della serie di dati proxy.

Fig.4. Schema di come una serie proxy (rosso) e una strumentale (blu) vengono confrontate in un loro periodo comune, per realizzare la calibrazione della serie proxy e verificare la bontà dell’operazione (validazione). La freccia nera in basso indica lo scorrere del tempo.

La metodologia presuppone omogeneità fra tutti i dati di ogni serie Proxy. Questa è una necessità, ma anche una distorsione dello spirito delle fonti. In genere, possiamo avere dei periodi comuni nel 1700, nel 1800 o nel 1900. Ma estendere il risultato di una calibrazione fatta nell’illuminismo o in età moderna a quanto scriveva un uomo del medioevo, è una forzatura che introduce un margine di incertezza (=errore) all’interpretazione di quanto scritto.

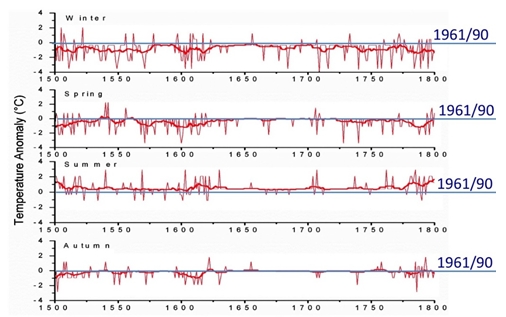

Anche i dati proxy soffrono di ben determinati limiti. Il livello Zero di base è soggettivo e legato all’esperienza del testimone. Pertanto non è possibile determinare trend o cambiamenti sul lungo periodo. Si prestano a evidenziare i cambiamenti brevi, o interannuali, ma la linea di base è necessariamente piatta (Fig.5) a meno che non si ricorra all’artificio di trasformare le frequenze in ampiezza. Ma questo altera profondamente la realtà delle cose.

Fig.5 Differenza tra i valori stagionali della temperatura in Italia centro-settentrionale ricostruiti tra il 1500 e il 1800 e il periodo di riferimento 1961/90. Tale differenza è chiamata “anomalia”. La linea spessa costituisce la media mobile su 11 anni e in presenza di picchi si discosta dal valore di base 0. Essa costituisce un filtro matematico dei picchi e non sostituisce l’andamento temporale che rimane a livello indeterminato.

I dati proxy sono affetti da un ampio margine di incertezza. Le condizioni dell’ambiente e delle tecnologie del passato sono diverse rispetto a quelle moderne. Questo costituisce una difficoltà nel confrontare l’intensità degli eventi sulla base degli effetti provocati. Un esempio con le precipitazioni. Si hanno notizie di nevicate abbondanti che hanno fatto crollare il tetti. La stima della quantità di neve caduta cambia con la solidità e la pendenza del tetto, specie quando il problema si riscontra in zone in cui la neve non è troppo frequente. Si può supporre che le esondazioni dei fiumi siano un indice di piogge intense, ma ogniqualvolta si sono rinforzati o alzati gli argini dei fiumi, le esondazioni sono diminuite. Quando nel medioevo il territorio era abbandonato a sé stesso e i fiumi erano contornati da paludi, una piena non cambiava gran che le cose e non veniva in alcun modo registrata. Quando sono stati costruiti centri abitati attorno ai fiumi, ogni esondazione causava danni irreparabili e entrava nella tradizione. Quando furono introdotti i mulini a acqua su zattere galleggianti ancorate a pali infissi nel letto del fiume, questi riducevano fortemente la portata e favorivano le esondazioni. Supponiamo che tra qualche secolo vengano persi i dati pluviometrici e che qualcuno voglia ricostruire l’intensità delle piogge dalla frequenza e dalla severità dei danni dovuti alle esondazioni: Pioggia = F(esondazioni). Costui cercherà e raccoglierà tutte le notizie scritte, e classificherà i fenomeni in ordine crescente basandosi sugli effetti sul territorio e sulla società presupponendo una semplice legge di progressione parallela tra causa e effetto. Se però scoprirà che delle esondazioni sono state peggiorate o causate da abusivismo edilizio condonato, da mancata manutenzione degli argini e del territorio, da cementificazione ecc., questo metterà in crisi la relazione “naturale” tra quantità di precipitazione necessaria per produrre esondazioni, estensione dell’area allagata e danno causato.

Conclusioni

Si è visto che il problema non è solo raccogliere i dati, ma effettuarne un’accurata correzione, omogeneizzazione e validazione per darne un’interpretazione corretta che sarà però affetta da certi limiti di incertezza che vanno chiaramente definiti e indicati. In mancanza di questo si rischia di interpretare come segnale climatico quanto è semplicemente un errore strumentale o un cambiamento nelle modalità operative o nell’ambiente.

Non è semplice disporre di lunghe serie omogenee e corrette, e l’incertezza aumenta con l’allontanarsi nel tempo. Purtroppo la ricerca in tale campo non è incoraggiata.

La precisione dei dati strumentali viene troppo spesso sopravvalutata e le disomogeneità intrinseche non sono sempre adeguatamente rimosse. I cambiamenti della tecnologia e dei protocolli di misura hanno influito sulle misure e questo è avvenuto simultaneamente su tutte le stazioni interessate, presentandosi con la veste di un cambiamento climatico. Il rischio di accontentarsi dei dati “disponibili” è di scambiare per segnale climatico quello che in realtà è una discontinuità o un errore.

Modelli matematici e osservazioni stanno indicando la tendenza al riscaldamento globale. La lezione del passato è che la situazione reale sia più complessa di quanto generalmente si creda.

In pratica, le osservazioni dirette e indirette ci danno alcune certezze, tra cui anche quella che dobbiamo tenere ben presente dei forti limiti di incertezza, a volte superiore a quanto venga generalmente creduto dai non specialisti in materia. La conoscenza scientifica ha, e deve avere, coscienza dei propri limiti e delle incertezze delle osservazioni e delle simulazioni. Tuttavia, la posta in gioco suggerisce di adottare prudenza. Il problema si sposta dal piano scientifico a quello politico, dell’opportunità e del buon senso.

Riferimenti bibliografici

Camuffo, D. e Bertolin, C., 2013: The world’s earliest instrumental temperature records, from 1632 to 1648, claimed by G. Libri, are reality or myth? Climatic Change, 119 (3-4), 647-657. DOI 10.1007/s10584-013-0742-3

Camuffo, D., e Jones, P. (editors), 2002: Improved Understanding of Past Climatic Variability from Early Daily European Instrumental Sources. Kluwer Academic Publishers, Dordrecht, Boston, London, 392 pp.

Camuffo, D., Bertolin, C., Diodato, N., Barriendos, M., Cocheo, C., Enzi, S., Sghedoni, M., E. Garnier, · M.-J. Alcoforado and · J. Luterbacher, 2011: Climate Change in the Mediterranean over the last five hundred years. Chapter 1, pp 1-26, in Elias Carayannis (Ed.) "Planet Earth 2011 - Global Warming Challenges and Opportunities for Policy and Practice", InTech - Open Access Publisher, Rijeka, Croatia .ISBN 978-953-307-733-8,

Cicala A., 1970: Meteorologia e strumenti. Levrotto & Bella, Torino.

IPCC, 2007: Climate change 2007: the physical science basis. Contribution of Working Group I to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change. In: Solomon, S., Qin, D., Manning, M., Chen, Z., Marquis, M., Averyt, K.B., Tignor, M., Miller, H.L. (Eds.), Cambridge University Press, Cambridge, UK.

Middleton, K.W.E. 1966: A history of the Thermometer and its use in Meteorology. J. Hopkins Press, Baltimore, USA.

WMO, 2008: Guide to meteorological instruments and methods of observation. WMO-8 8 1-681, World Meteorological Organization, Geneva.

WMO, 2009: World Meteorological Organization at a glance. WMO, Geneva

CARATTERISTICHE ED ANDAMENTO CLIMATICO NEL VENETO

Dr. Marco Monai – Dr. Francesco Rech

ARPAV- Servizio Meteorologico

1 - Premessa

Il Veneto presenta caratteristiche climatiche peculiari data la sua collocazione e conformazione geografica. La distribuzione spaziale e temporale di precipitazioni e temperature risente fortemente del contributo di fattori locali.

Nel seguito ci si sofferma su tali peculiarità, nonché si evidenziano alcuni trend evolutivi che risultano, invero, ben definiti per quanto attiene alle temperature e assai meno chiari a riguardo delle precipitazioni.

Nell’ultima parte si trattano alcuni eventi meteorologici particolari verificatisi negli anni più recenti.

2 - Le Precipitazioni nel Veneto

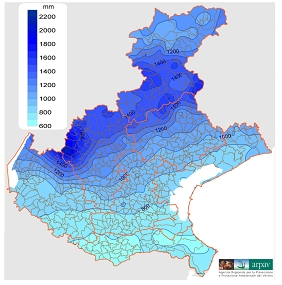

La figura 1 rappresenta la distribuzione spaziale, sul territorio della regione Veneto, della precipitazioni annuale espressa in mm (media riferita al periodo 1981-2010).

Figura 1 – Distribuzione della precipitazione media annua sul Veneto.

E’ possibile osservare come, nello spazio di circa 90 km tra il Polesine e l’alta valle dell’Agno in prossimità del gruppo Pasubio-Carega, le precipitazioni annuali variano tra i 600-700 mm ed i 2000 mm. Più in generale è ben evidente l’incremento della piovosità media annua, procedendo dai confini meridionali della regione verso la barriera prealpina che, intercettando i flussi meridionali delle perturbazioni, determina una concentrazione dei fenomeni meteorici su quest’area.

Più a nord delle Prealpi, oltre la Val Belluna, i rilievi dolomitici meridionali determinano un’ulteriore area di incremento delle precipitazioni annuali, che raggiungono valori non dissimili da quelli registrati sulla fascia prealpina. Infine nelle Dolomiti centrali e settentrionali si osserva un tendenziale decremento degli apporti medi annui.

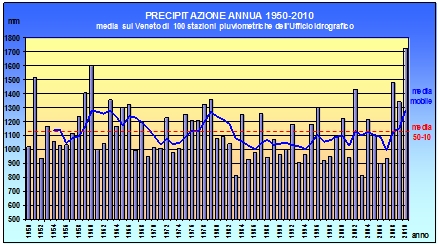

Utilizzando i dati pluviometrici di 100 stazioni dell’Ufficio Idrografico, selezionate in base alla migliore consistenza delle serie storiche pluviometriche nel periodo 1950-2010, si è effettuata una media dei valori di precipitazione annuale per il territorio della Regione Veneto.

Nel grafico in figura 2 sono state riportate: le precipitazioni annuali (istogrammi), la precipitazione annuale media del periodo 1950-2010 (retta tratteggiata rossa) e la media mobile su un periodo di 5 anni (linea continua blu).

Osservando la media mobile risulta evidente che tra gli anni ‘50 ed i primi anni ’80 sono presenti due ampie oscillazioni attorno alla media del periodo, successivamente la media mobile permane stabilmente sotto la media 1950-2010 con oscillazioni limitate e, solo negli ultimi tre anni del periodo considerato (2008-2009-2010), la media mobile si riporta decisamente al di sopra della media del periodo. In questa serie non si evidenzia la presenza di un trend significativo delle precipitazioni

Si osservi che nell’ultimo decennio vengono registrate sia le massime precipitazioni (2010) sia le minime (2003) dell’intera serie sessantennale.

Figura 2 – Andamento delle precipitazioni annuali nel periodo 1950-2010 (media delle osservazioni di 100 stazioni pluviometriche dell’Ufficio Idrografico del Magistrato alle Acque di Venezia).

Anche considerando le misure di precipitazione effettuate dall’ARPAV nel periodo 1992-2014, con una rete di circa 160 stazioni meteorologiche automatiche, si constata che, oltre alle significative precipitazioni degli anni 2008-2009 e 2010, anche le precipitazioni negli anni 2013 e 2014 sono nettamente superiori alla media ed in particolare i valori del 2014 risultano sensibilmente superiori anche agli apporti del 2010. D’altra parte l’andamento di pochi anni non è sufficiente ad individuare eventuali tendenze climatiche che vanno valutate su periodi almeno trentennali ed inoltre il corrente anno 2015 presenta, al momento, precipitazioni inferiori alla media.

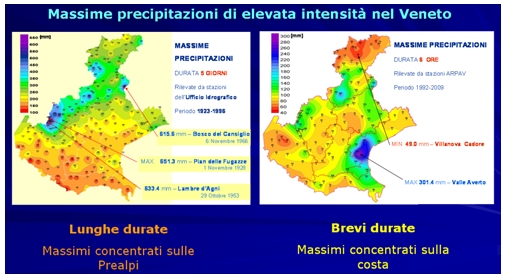

Figura 3 – Localizzazione dei massimi valori assoluti delle precipitazioni della durata di 5 giorni consecutivi e di 6 ore.

C’è molto interesse per le precipitazioni di elevata intensità per gli effetti che hanno sul territorio in termini di allagamenti localizzati o addirittura di fenomeni alluvionali. Vengono di seguito considerati due differenti casi costituiti dalle precipitazioni di lunga durata (5 giorni consecutivi) e dalle precipitazioni di breve durata (6 ore consecutive).

Nella figura 3 è possibile osservare che:

• le massime precipitazioni assolute della durata di 5 giorni consecutivi si localizzano sulle Prealpi e sulle Dolomiti meridionali (in analogia alla localizzazione dei massimi valori di precipitazione media annua) con valori che superano i 600 mm mentre sulla pianura meridionale tali valori sono di 100-150 mm;

• le massime precipitazioni assolute della durata di 6 ore consecutive al contrario si localizzano sull’area costiera con piogge che hanno raggiunto i 300 mm di precipitazione; tali eventi apportano in poche ore il 30-40% dell’ammontare della precipitazione media che cade nell’arco di un anno.

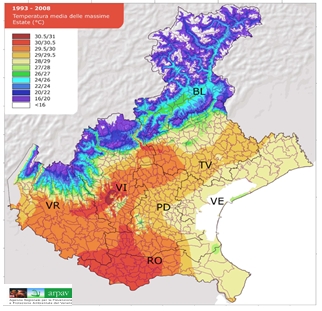

3 - Le Temperature in Veneto

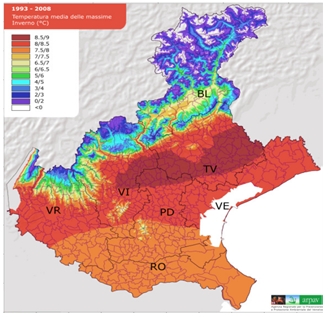

La figura 4 riporta la carta delle isoterme relative alle temperature massime estive (media del periodo 1993-2008). I massimi valori si localizzano sulle aree centro-occidentali della pianura (effetto “continentale”).

Figura 4 – Temperature medie delle massime in Estate.

Figura 5 – Temperature medie delle massime in Inverno.

Si osserva, invece, una mitigazione dei valori termici massimi avvicinandosi alla costa e nei pressi del Lago di Garda. Ben evidente è anche l’effetto di diminuzione delle temperature massime con l’aumentare della quota (colli Euganei, Berici, Montello e montagna).

La figura 5 riporta l’andamento delle temperature massime invernali; si osserva la scomparsa dell’effetto di mitigazione costiera o lacustre e sulla Pianura i valori termici massimi aumentano gradualmente verso settentrione; ciò è dovuto alla minor frequenza delle nebbie sull’alta pianura e sulla pedemontana.

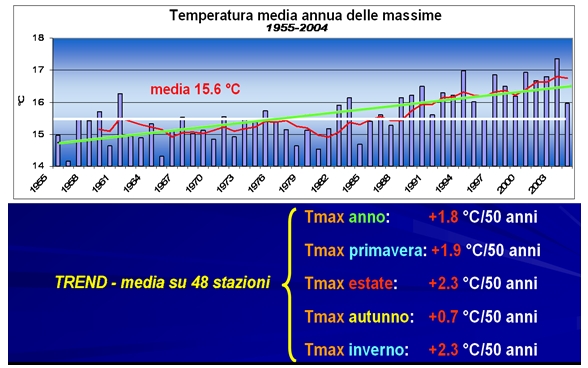

Esaminando l’andamento delle temperature medie annuali nel cinquantennio 1955-2004 (dati termometrici di 48 stazioni dell’Ufficio Idrografico del Magistrato alla Acque di Venezia) si riscontra la presenza di un trend in aumento statisticamente significativo.

Figura 6 – Trend delle temperature massime annuali nel periodo 1955-2004 (dati Ufficio Idrografico).

In particolare in figura 6 viene riportato l’andamento delle medie annuali delle temperature massime giornaliere. Nel periodo 1955-2004 il trend di aumento risulta essere di circa 1.8 °C in 50 anni. L’incremento delle massime risulta essere:

• più marcato in estate ed in inverno (+2.3 °C in 50 anni)

• meno accentuato in primavera (+1.9 °C in 50 anni) e soprattutto in autunno (+0.7 °C in 50 anni).

Anche le temperature minime presentano un significativo trend in aumento che su base annua risulta essere di 1.1 °C in 50 anni. Anche in questo caso l’aumento delle minime risulta essere:

• più marcato in estate (+1.6 °C in 50 anni) ed in inverno (+1.2 °C in 50 anni)

• meno accentuato in primavera (+1.0 °C in 50 anni) ed in autunno (+0.7 °C in 50 anni).

Tale trend è confermato anche negli anni più recenti dalle osservazioni effettuate dalla rete di stazioni meteorologiche dell’ARPAV.

L’aumento delle temperature in Veneto trova anche delle conferme indirette dall’esame di alcuni fenomeni:

• dall’analisi delle somme termiche negli anni più recenti si evidenzia un accorciamento del periodo di maturazione della vite valutato mediamente in 15-20 giorni; tale fenomeno trova conferma dalle indagini in campo effettuate dal CREA – Centro di Ricerche per la Viticoltura di Conegliano (TV);

• è stata monitorata la progressiva riduzione, dal 1875, della superficie del ghiacciaio della Marmolada; in generale la superficie glacializzata sulle Dolomiti si è ridotta di circa il 49% negli ultimi 100 anni con un’accelerazione della fase di ritiro a partire dal 1980 (si specifica che questo fenomeno è comunque dipendente dall’effetto combinato di temperature e precipitazioni).

4 - Il tempo atmosferico degli ultimi anni

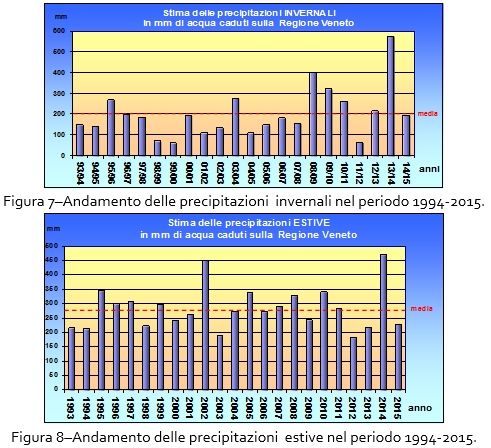

L’anno 2014 in Veneto ha presentato le seguenti peculiarità:

• le precipitazioni invernali, come risulta in figura 7, (dicembre 2013-gennaio e febbraio 2014) sono le più elevate dell’ultimo ventennio (ovvero da quando ARPAV ha avviato le misure con stazioni automatiche) e dal 1920 hanno raggiunto totali simili solo nell’inverno 1950-1951;

• anche le precipitazioni estive, come risulta in figura 8, sono le più elevate del ventennio grazie soprattutto agli apporti del mese di luglio;

• le temperature medie dei mesi di gennaio febbraio e novembre risultano molto elevate rispetto alla norma mentre le temperature di luglio ed agosto risultano molto inferiori alla media;

• complessivamente l’anno 2014 risulta essere il più piovoso del ventennio e, su buona parte dei punti di misura, risulta essere anche l’anno più caldo del ventennio nonostante l’andamento delle temperature estive.

Nel corrente anno 2015 le temperature medie dei mesi da gennaio ad agosto risultano tendenzialmente superiori alla media ventennale; in particolare, il mese di luglio risulta il più caldo della serie ventennale. E’ interessante osservare che la media delle temperature massime del mese di luglio se nel 2015 risulta la maggiore dal 1994, nel 2014 risultava la minore.

Tra gli eventi “estremi” verificatisi di recente si ricordano:

• l’alluvione del 30 ottobre – 2 novembre 2010, durante la quale vengono misurate precipitazioni di 400-500 mm in varie località delle Prealpi e con un massimo assoluto di 587 mm sul Monte Grappa (BL);

• l’alluvione del 30 gennaio-4 febbraio 2014, particolare in quanto si verifica in un periodo dell’anno tipicamente caratterizzato da scarse precipitazioni, durante la quale vengono registrate precipitazioni sulle Prealpi di 250-400 mm con massimo assoluto di 568 mm sul Monte Grappa (BL);

• l’allagamento di Mestre verificatosi durante il nubifragio del 26 settembre 2007 nel corso del quale vengono misurati a Campagna Lupia - Valle Averto (VE) 301 mm di pioggia caduti in 6 ore;

il tornado abbattutosi sulla Riviera del Brenta (VE) l’8 luglio 2015 che sulla base dei danni provocati è stato classificato come F4 (scala

SCHEDA RIASSUNTIVA DELLA PRESENTAZIONE CLIMA GLOBALE E FABBISOGNI ENERGETICI

Ernesto Pedrocchi

La presentazione “Clima globale e fabbisogni energetici” di Ernesto Pedrocchi al Convegno di Padova “Storia ed evoluzione del clima terrestre” del 28-10-2014 dopo una premessa relativa alla differenza tra clima globale e clima locale e tra inquinanti e anidride carbonica -CO2- (slides 2,3 e 4) si è articolata in 5 capitoli.

Il cap.1 presenta un quadro sintetico della storia del clima globale degli ultimi 500.000 anni tramite l’analisi della temperatura globale media (Tgm) per aiutare a contestualizzare la situazione attuale. Risulta dalle slides 6,7,8 e 9 che ora siamo a un livello di Tgm massimo rispetto a tutti i valori del periodo della rivoluzione industriale, ma nei 10.000 anni dopo l’uscita dall’ultima glaciazione si sono raggiunti valori maggiori; inoltre nell’ultimo periodo interglaciale, circa 125.000 anni orsono, la Tgm era nettamente superiore all’attuale e il mare mediterraneo era a un livello di circa 8 m superiore all’attuale. In sintesi la temperatura del pianeta è sempre variata per cause naturali ben prima che ci fosse l’uomo e la situazione attuale non si presenta come anomala nella storia del clima.

Nel cap. 2 si analizza il legame tra aumento della concentrazione di CO2 nell’atmosfera ed emissioni antropiche dello stesso gas. Questo legame viene dato per scontato, ma al riguardo ci sono alcuni dubbi. La tempistica di crescita delle due grandezze: la concentrazione ha iniziato a crescere ben prima che le emissioni fossero appena appena significative. La concentrazione cresce egualmente nei due emisferi, mentre le emissioni antropiche sono prevalentemente concentrate nell’emisfero nord sopra al tropico del cancro ed è scientificamente provato che l’equatore è a livello atmosferico una barriera abbastanza rigida (slides 11, 12 e 13). Infine le emissioni antropiche sono in continua crescita, ma hanno avuto dei rallentamenti per cause varie di cui non è rimasto alcun segno nell’aumento della concentrazione in atmosfera. In sintesi si può dire che è possibile che l’aumento della concentrazione di CO2 in atmosfera sia anche conseguente le emissioni antropiche, ma ci sono altri fattori che agiscono sul fenomeno.

Nel cap. 3 si analizza il legame tra concentrazione di CO2 in atmosfera e Tgm evidenziando che nella storia del clima da circa 500.000 anni l’entrata e l’uscita dalle glaciazioni sono sempre state innescate dai fattori orbitali sole/terra (questo è riconosciuto anche da IPCC) e la variazione di concentrazione di CO2 segue in generale la Tgm (slides 17 e 18). Inoltre si mostra che dall’uscita dall’ultima glaciazione, all’incirca 10.000 anni fa, ad ora non c’è correlazione tra andamento della concentrazione di CO2 in atmosfera e Tgm. In sintesi, pur essendo la CO2 un gas serra, che ha però quasi esaurito il suo potenziale, non c’è prova nella storia recente del clima che essa abbia avuto un’influenza significativa sul clima terrestre.

Nel cap. 4 si segnalano gli effetti del sole, molto probabilmente il driver naturale più importante, sul clima terrestre. In particolare (slides 24 e 25) si evidenzia il legame tra cicli delle macchie solari e clima terrestre e nella slide 26 si presenta l’attuale sorprendente evoluzione dei cicli delle macchie solari.

Nel cap. 5 si analizzano le strategie a priori perseguibili per contenere i possibili danni derivanti da cambiamenti del clima globale.

La strategia della mitigazione, ovvero il contenimento e la riduzione delle emissioni antropiche di CO2, è attualmente molto perseguita, ma presenta diversi problemi (slide 29). Non è scientificamente accertato che sia la CO2 antropica che causa l’aumento della concentrazione di questo gas in atmosfera, ne tanto meno accertato che causi aumento della Tgm. Inoltre il contenimento delle emissioni antropiche, se fossero responsabili di cambiamento del clima globale, dovrebbe essere perseguito da tutti, ma ciò è impensabile per ragioni socioeconomiche (tuttora i combustibili fossili coprono circa l’80% del fabbisogno energetico mondiale). C’è il grave rischio della delocalizzazione delle attività particolarmente energivore con peggioramento del quadro globale. In sintesi si può pensare che la strategia della mitigazione, anche ammesso, come pura ipotesi, che le emissioni antropiche di CO2 fossero responsabili del cambio del clima globale, è una strada impercorribile. Ovviamente questo non comporta che non si debba perseguire la strada dell’efficienza nella gestione dei processi energetici.

In alternativa c’è la strategia dell’adattamento che consiste in: (‘) Identificare gli effetti dannosi più probabili e le aree più vulnerabili, (‘’) studiare e progettare interventi graduali di adattamento e protezione, (‘’’) realizzare gli interventi con una opportuna scala di priorità. Questa strategia è stata perseguita dall’uomo da quando esiste e comporta notevoli vantaggi: (‘) Interventi validi indipendentemente dalla causa antropica o naturale del fenomeno, (‘’) Interventi mirati, con tecnologie note e già praticate, tempi di intervento congruenti con l’insorgere dei danni, con buona probabilità di successo su problemi in generale già esistenti, (‘’’) strategia valida anche se perseguita unilateralmente.

In sintesi la strada da seguire per contenere gli eventuali danni conseguenti a cambiamenti del clima è la strategia dell’adattamento e della efficienza energetica non quella del solo contenimento delle emissioni di CO2. Questo è anche il risultato di un importante studio attuato nel 2015 dal “ Copenhagen Consensus Center” (B. Lomborg) al quale hanno partecipato alcuni tra i più prestigiosi economisti, di cui 7 Premi Nobel.

LE ERUZIONI VULCANICHE E IL CLIMA: DALL'ANNO SENZA ESTATE (1816) AL RISCALDAMENTO DEGLI OCEANI

PAOLA PETROSINO

Dipartimento di Scienze della Terra, dell’Ambiente e delle Risorse Università di Napoli Federico II

In questo intervento vengono affrontate le relazioni che intercorrono tra le eruzioni vulcaniche e il clima, in termini di effetti sia a livello locale che a scala globale. L'intervento affronta la storia della relazione tra vulcani e clima, le osservazioni, i fattori e gli effetti delle eruzioni vulcaniche in rapporto al clima, gli strumenti per estendere il record dei dati osservati e investigati con un approccio scientifico e, da ultimo, il vulcanismo sottomarino in termini di potenziale fonte di calore e CO2 per l'oceano.

Vulcani e clima: storia di una relazione

Le eruzioni vulcaniche possono essere di tipo effusivo, durante le quali il magma viene emesso in maniera tranquilla e senza che si crei un accumulo di gas, e i cui prodotti sono rappresentati da flussi di lava più o meno viscosa a seconda delle caratteristiche (contenuto in silice, temperatura…) del magma di partenza. Le eruzioni vulcaniche esplosive, invece, sono caratterizzate da risalita del magma in condizioni tali che l'effetto della diminuzione della pressione su di esso sia un'improvvisa e violenta liberazione dei gas che porta alla frammentazione del magma stesso e delle rocce incassanti, e alla dispersione in atmosfera di una miscela di frammenti di differenti dimensioni e gas (prevalentemente H2O, CO2, SO2). I frammenti eiettati, le cui dimensioni variano a partire da dimensioni dell'ordine dei micron, sono detti piroclasti e vanno a costituire una colonna eruttiva di altezza compresa tra alcuni chilometri e 50 chilometri a seconda della VEI (Volcanic Explosivity Index) dell'eruzione.

Nel passato non è stato facile mettere in relazione piccole variazioni della situazione meteorologica con eruzioni vulcaniche che magari avvenivano in aree molto distanti, soprattutto in assenza di mezzi di informazione come quelli attuali grazie ai quali le notizie viaggiano in tempo reale. Benjamin Franklin fu il primo ad ipotizzare una connessione tra l'attività vulcanica e il clima. Quando nel 1784 prestava servizio a Parigi come ambasciatore dei "neonati" Stati Uniti d’America, infatti, scrisse che durante l'estate del 1783, quando ci si sarebbero aspettati cieli limpidi e temperature elevate, una fitta nebbia ricopriva tutta l'Europa e gran parte del Nord America, e che l'inverno del 1783-1784 poteva essere considerato di gran lunga il più rigido di quelli registrati da molti anni. Egli poneva in relazione questi fenomeni con un'eruzione avvenuta in Islanda, in particolare nel vulcano Hekla, che all'epoca era senza dubbio il vulcano islandese più noto. Ora noi sappiamo che il 1783 fu l'anno dell'intensa eruzione fissurale del Laki, in Islanda, a cui andrebbero piuttosto ascritti gli effetti osservati da Benjamin Franklin. La densa nebbia fu notata da molti studiosi britannici; in particolare Thomas Barker, un signorotto inglese appassionato di osservazioni meteorologiche, descrisse il fenomeno e scrisse che esso si poteva paragonare a quello enumerato da Plutarco tra i prodigi verificatisi in concomitanza della morte di Cesare nell'anno 44 a.C. Baker testimoniava anche che, a differenza dell'estate descritta da Plutarco per il 44 a.C., l'estate del 1783 in Inghilterra era stata calda, cosa che aveva notevolmente anticipato la maturazione dei raccolti e che, soprattutto nell'Europa Settentrionale, in conseguenza dell'acidità della foschia i raccolti erano stati notevolmente danneggiati.

L’eruzione del Tambora, stratovulcano dell'isola di Sumbawa, situata nell'arcipelago indonesiano della Sonda, avvenuta l’11 aprile del 1815, fece registrare un VEI (Volcanic Explosivity Index) pari a 7, e comportò il rilascio di 50 km3, espressi in termini di Dense Rock Equivalent, di magma trachiandesitico, in parte messi in posto come prodotti da caduta da una colonna pliniana, ma in massima parte come correnti piroclastiche e relativa nube co-ignimbritica. L'eruzione viene ricordata soprattutto per i suoi effetti sul clima, e per i particolari effetti ottici che si verificarono in concomitanza di essa (Stothers, 1984).

Questa eruzione ebbe conseguenze climatiche che vennero avvertite in tutto il mondo, ed in particolare in Europa, USA e Canada. Il 1816 fu definito l’anno senza estate. Negli Stati Uniti orientali, in luglio e agosto le temperature medie rimasero attorno a 4°C. Attorno al 20 agosto le minime scesero sotto lo zero. Per tutta quell’estate gelo e neve distrussero i raccolti. Sembra che come conseguenza di questa eruzione l'emigrazione verso l'Ovest degli Stati Uniti abbia subito un impulso. Per quanto riguarda l'Europa, l'eruzione, che avvenne solo un anno dopo la fine delle guerre napoleoniche, sommò i propri effetti a una situazione economico-politica già molto disastrata, e nel mondo occidentale si verificarono carestie, epidemie e tumulti, e forte fu l'impulso verso un'emigrazione su larga scala.

Tramonti dai colori brillanti e crepuscoli prolungati furono un altro degli effetti che l'eruzione fece registrare nell'Europa centro-settentrionale, effetti che furono facilmente classificabili come anomali, nonostante il rosso dei tramonti fosse comunemente registrato nei cieli grigi di Londra. Questo fece sì che l'eruzione del Tambora lasciasse un segno anche nell'arte: William Turner, detto anche “il pittore delle luce”, avrebbe dipinto i tramonti e le albe di Londra con una luce che appariva condizionata dagli effetti dell’eruzione. Trascorrendo la piovosa e fredda estate del 1816 sul Lago di Ginevra, Mary Shelley ebbe l'opportunità, forse condizionata dall'impossibilità di uscire a passeggio, di comporre il suo fortunato romanzo Frankenstein e Lord Byron scrisse, nel poemetto Darkness, del 1816, versi che richiamano la cupezza del tempo e delle atmosfere che probabilmente lo circondavano.

L’eruzione del Krakatau, anch’esso situato nell'arcipelago indonesiano, a sud di Sumatra, avvenuta tra il 26 e il 27 agosto 1883, fu caratterizzata da una colonna eruttiva la cui altezza superava i 40 km. I frammenti più grossolani caddero al suolo piuttosto rapidamente, ma quelli più sottili furono trasportati per alcuni mesi nella fascia intertropicale dell'atmosfera. A far ricordare il Krakatau sono stati soprattutto i fenomeni ottici legati agli effetti dovuti al dust veil che caratterizzarono i mesi successivi all’eruzione. Il report prodotto da Rollo Russell e Douglas Archibald per la Royal Society of London aveva infatti come sottotitolo "On the unusual optical phenomena of the atmosphere, 1833-1866, including twilight effects, coronal appearances, sky hazes, colored suns, and moons, etc."

Anche l’eruzione del Krakatau ha lasciato la sua traccia nell’arte. Tra tutti va ricordato l’artista norvegese Munch, che racconta lui stesso come il dipinto “L’urlo” (1893) fu ispirato da un tramonto particolare, a cui egli assistette ad Oslo: "Camminavo lungo la strada con due amici quando il sole tramontò, il cielo si tinse all'improvviso di rosso sangue. Mi fermai, mi appoggiai stanco morto ad una palizzata. Sul fiordo nero-azzurro e sulla città c'erano sangue e lingue di fuoco. I miei amici continuavano a camminare e io tremavo ancora di paura... e sentivo che un grande urlo infinito pervadeva la natura". Agli anni successivi al 1883 rimandano anche i cinquecento acquarelli dell’artista britannico Ashcroft, della collezione “Cieli del Krakatau”, in cui sono dipinti gli effetti dell'eruzione sui cieli di varie città. Per quanto riguarda la letteratura, va ricordato il poemetto di Tennyson intitolato "St. Telemachus", parte della sua ultima opera, The Death of Oenone, Akbar's Dream, and Other Poems, pubblicata nel 1892. Nei primi versi del poemetto il poeta parla delle ceneri di un vulcano, che sono in grado di attraversare l'atmosfera dell'intero globo. Il riferimento al Krakatau è chiaro, se teniamo conto del fatto che nel 1883 la notizia era stata riportata dalla stampa occidentale con dovizia di particolari.

Vulcani e clima: le osservazioni

Fin qui quelle sono state trattate relazioni tra eruzioni vulcaniche e clima che ci provengono da fonti indirette, diciamo così, più descrittive che scientifiche (Francis e Oppenheimer, 2004). Tre importanti eruzioni accadute nel secolo scorso, l'eruzione del Agung, a Bali, in Indonesia, verificatasi il 17 maggio 1963, l'eruzione del vulcano El Chichòn, in Messico, del 28 Marzo 1982 e l'eruzione del vulcano Pinatubo, Filippine, accaduta il 12 Giugno1991, hanno permesso di investigare con un approccio scientifico

le conseguenze sul clima di eruzioni vulcaniche.